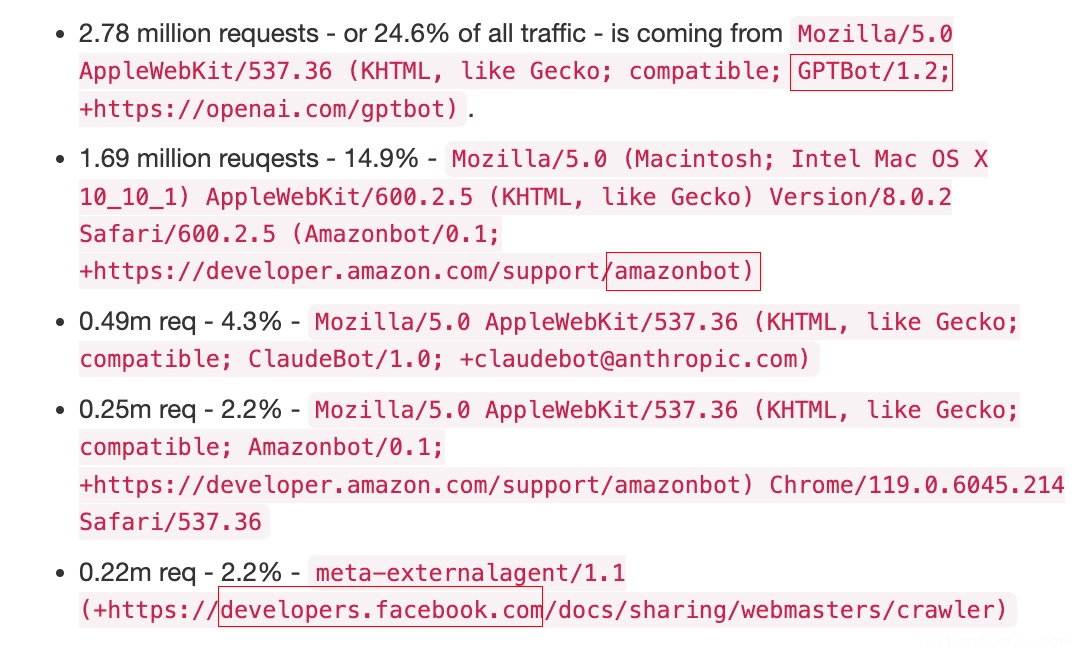

近期,Dennis Schubert发布了一则帖子,称 “diaspora*” 项目的网络基础设施因为访问流量过大而陷入了性能瓶颈。令人震惊的是,他发现70% 的请求来自 IT 巨头公司的 LLM(大语言模型)爬虫。这些爬虫无视 robots.txt 文件,贪婪地抓取网站的所有可用数据,甚至是一些无关紧要的内容。

Dennis 感到无比愤怒,因为 ChatGPT 和 Amazon 的爬虫竟然爬取了 Wiki 的全部编辑历史,每一页的每次编辑都被记录下来。他质问:

“他们到底要做什么?是想研究文本如何随时间变化吗?”

这种对数据的无底线掠夺,导致服务器负载极高,用户访问体验显著下降。Dennis 尝试了一些反制措施:

- 更新 robots.txt:无效,爬虫无视规则。

- 限制访问速率:失败,爬虫会快速更换 IP。

- 屏蔽 User Agent:没用,爬虫伪装成普通用户。

最终 Dennis 感慨,这种行为已经接近于对整个互联网的DDoS 攻击。

为什么 IT 巨头需要爬我们的数据?

答案是:AI 数据饥荒。

随着大模型的普及,用于训练 AI 的高质量语料已经见底。正如 OpenAI 工程师 James Betker 所言:

“模型优劣的关键在于数据集的质量。它们正在以惊人的精度复刻数据集。”

为了在 AI 竞赛中领先,巨头们不惜一切代价获取更多数据。个人网站、自建 Wiki,这些原本属于小众的内容,正成为巨头们争相攫取的目标。

我们能够应对吗?

IT 巨头拥有顶尖的爬虫和反爬虫技术团队,能够在抓取与用户体验之间找到平衡。但对于个人网站和小型项目来说,这无疑是一场不对等的战争。

Dennis 提出了以下两种反制策略:

- Tarpit 技术:生成无意义的随机文本,诱导爬虫抓取无关内容。

- JavaScript 陷阱:让 AI 爬虫加载 JavaScript 才能获得数据,而这些脚本可能暗含挖矿代码。

尽管这些方法可能有效,但实现起来成本不菲。

没有链接的互联网

巨头公司的终极目标是什么?

是将用户牢牢锁定在他们的生态系统中。通过 AI 提供“最优内容”,用户无需访问其他网站,甚至看不到其他链接。一切内容直接呈现,广告作为附加品,而创作者只能沦为巨头的数据供应商。

这种趋势正在瓦解互联网的开放性。

无论你如何优化 SEO 或产出优质内容,巨头的 AI 会优先抓取并整合,用户永远不会直接访问你的网站。最终,个人创作者将失去流量与收入,整个互联网变成巨头的“金矿”。

总结

IT 巨头正在用技术手段,掠夺数据,榨取价值,逐步摧毁互联网的多样性与开放性。对于个人网站而言,我们几乎无力抗争,而这场改变已经不可逆。